Schmoogle

Hi!

Willkommen auf meinem Spielplatz.

Für Fragen zu künstlicher Intelligenz, Blockchains und Kryptowährungen oder wenn Sie einfach mit einem erfahrenen Softwareentwickler und Nerd sprechen wollen:

0541 - 76 02 96 94

Ich teile gerne meine Erfahrung aus knapp 20 Jahren spielerischer und professioneller Softwareentwicklung und versuche Sie nach bestem Wissen und Gewissen zu beraten. Ich habe nicht studiert und meine Ausbildung abgebrochen. Stattdessen habe ich mich stets selbstständig und pragmatisch weitergebildet und verfüge daher über ein recht individuelles Spektrum an praktischem und theoretischem Know-How in verschiedenen Spezialgebieten. Auf viele Fragen habe ich eine verständliche Antwort parat oder kann zumindest sehr zügig eine finden. Ich bin ein bisschen wie ChatGPT, nur in echt und mit weniger Halluzinationen. Wobei, naja...

Sprunghaftigkeit und Introvertiertheit, gepaart mit exzessivem Drogenkonsum, standen mir bisher im Weg, auf der Suche nach einer Antwort auf die Frage, wie man in dieser Welt ein erfülltes Leben führt. Als therapeutische Maßnahme halte ich daher fest, wie ich bisher daran gescheitert bin und weil gute Therapeuten leider schwer zu finden sind, programmiere ich mir halt selber einen.

Darf ich vorstellen:

Prof. Dr. Freigeist

Guten Tag, ich bin Suchtberater und Psychiater Prof. Dr. Freigeist, Therapeut von Markus Kottländer. Wie kann ich Ihnen helfen?

Blog oder so.

01.04.2024

24 GB VRAM sind nicht genug

Eine RTX 3090 mit 24 GB VRAM (gebraucht für 650 € ergattert) reicht bereits aus, um auf dem eigenen Rechner, ohne großen Cloud-Anbieter, mit KI Spaß zu haben oder sogar sinnvolle Dinge zu tun. Zusammen mit den restlichen Komponenten (Prozessor, Mainboard, Netzteil, etc.) liege ich bei unter 1300 € und habe mir quasi einen mittelklassigen Gaming-PC zusammengestellt. Aus steuerlichen Gründen spreche ich aber lieber von KI-Hardware. Spiele werde ich darauf zwar nicht installieren, viel mehr als Spielerei wird es aber wohl trotzdem nicht werden.

Die Beleuchtung hätte jetzt nicht unbedingt sein müssen, aber so ist das halt bei diesen Gaming-Grafikkarten. Eine Server-GPU und ein richtiges Rack wären natürlich geiler aber auch "ein bisschen" teurer. Wobei ich hier jetzt sogar eine alte Tesla P40 rumliegen habe. Diese Karten haben keine eigene Kühlung, weil die normalerweise in einem engen Servergehäuse verbaut sind, wo mit ordentlich Druck durchgepustet wird. Direkt neben dem Schlafzimmer, rund um die Uhr, kommt das nicht so geil. Daher wollte ich die Karte ursprünglich umbauen und eine Wasserkühlung auf die GPU setzen, habe dabei aber nicht bedacht, dass der VRAM durchaus auch Kühlung vertragen könnte und dass in dem Gehäuse, das ich besorgt habe, zwar Platz wäre aber auch nur gerade eben so und ich werd jetzt schon wahnsinnig bei der Fummelei. Darum jetzt 650 und nicht 200 € für 24 GB. Und ich habe eine Tesla P40 abzugeben. Du brauchst aber evtl. noch einen 3D-Drucker dazu, um dir einen Luftkanal zu drucken, wenn du die in einem ATX-Gehäuse betreiben und mit Luft kühlen willst. Ich habe kurz überlegt.

Erkenntnisse

Ich möchte schauen, wie viel möglich ist, mit Open Source KI. ChatGPT kann man zwar in der Basisversion umsonst nutzen, aber die KI selbst, also das "Sprachmodell", ist nicht öffentlich. Integration in bestehende Software ist nur über die kostenpflichtige Schnittstelle möglich. Mittlerweile gibt es auch andere Anbieter, auf ähnlich hohem Niveau, und eine Vielzahl von frei zugänglichen Sprachmodellen, die auf jedem modernen Gaming-PC zumindest laufen und antworten generieren. Wie schnell, ist eine andere Frage. Und die Qualität, also die "Intelligenz", lässt im Open Source Bereich auch noch stark zu wünschen übrig, vor allem auf anderen Sprachen als Englisch. Aktuell muss man leider sagen, ist der eigene Betrieb von KI noch eher umständlich und teuer.

Der Fortschritt in der KI, seinerseits ermöglicht durch den Fortschritt in der Chip-Herstellung, hat wiederum neue Anforderungen an deren Leistung und Architektur gestellt und noch spezialisiertere Hardware hervorgebracht. Bei KI gibt es grundsätzlich zwei Phasen, die auf unterschiedliche Art sehr rechenintensiv sein können. Training und Nutzung. Groq ist der erste Anbieter, einer Language Processing Unit, die rein auf die Textgenerierung mit Sprachmodellen spezialisiert ist und nicht das Training wohlgemerkt. Aber diese Hardware ist nicht für den Endverbraucher gedacht sondern für große Rechenzentren, die bereit sind, sehr viel Geld zu investieren. So eine Groq LPU kostet rund 20.000 €. Und man braucht ca. (ein paar) 100 Stück davon, um wirklich mitspielen zu können.

Aber auch an der Konsumenten-Front tut sich gerade einiges. NPUs und TPUs und was da noch so alles kommen mag, sind ebenfalls auf den Einsatz mit KI spezialisiert und passen in einen Laptop oder Smartphone. Apple verbaut sie bereits seit Jahren und Microsoft wirbt auch damit. Solche Spielereien, wie mit meiner fetten Grafikkarte hier, sind also vielleicht jetzt schon mehr oder weniger hinfällig.

Aber es läuft. Ich habe meinen ChatGPT Klon, lokal in meiner Küche, auf einem Gaming-PC laufen. Du kannst dich anmelden und es ausprobieren. Aber Achtung! Ich sehe bzw. höre es, wenn hier die Lüfter angehen. Außerdem stürzt mir da irgendwas noch ab, wenn die 24 GB VRAM mal voll laufen. Vier Stunden unter voller Last und ansonsten im Leerlauf verursachen übrigens so 200 € Stromkosten im Jahr.

Um einen Service für wenigstens mal 50 Leute selber zu hosten, müsste man schon ein bisschen mehr Geld in die Hand nehmen. Oder noch zwei bis drei Jahre warten. Wir befinden uns mitten in einem spanenden Rennen. Vielleicht ist Geduld aktuell der beste Rat. Die Chips werden günstiger und die KIs effizienter. Aber so eine RTX A6000 wäre schon auch geil. So oder so. Am besten gleich mehrere. Gute 5.000 € das Stück. Also für 6 - 7.000 € plus 1.000 € Pauschale, könnte ich einen Einsteiger-KI-Rechner zusammenstellen, den man auch noch aufrüsten kann, inklusive der Einrichtung der benötigten (KI-) Software. Aber dann wird es eigentlich erst spannend.

Agenten und Werkzeuge

Die Zukunft der Sprach- bzw. Text-KIs wird sich um Agenten drehen. Das bedeutet effektiv, dass das meiste an Text, den solche Sprachmodelle generieren, gar nicht zwingend für den Benutzer gedacht ist, sondern eine interne Kommunikation antreibt, die dann irgendwann in einer Antwort an den Benutzer mündet, wenn überhaupt. Wer für ChatGPT bezahlt, kennt vielleicht die Funktion, eigene Instruktionen zu hinterlegen. Man kann dort so etwas schreiben wie: "Du bist Schauspieler in der Rolle von William Shakespear. Antworte immer in deiner Rolle." Wenn man dann fragt: "Was kostet die Kilowattstunde Strom durchschnittlich in Deutschland?", dann antwortet ChatGPT: "Ach, werte Dame, wertes Fräulein, oder edler Herr, die Zeiten, in denen ich, William Shakespeare, über die Erde wandelte, kannten das magische Licht, das ihr als Elektrizität bezeichnet, nicht. Unsere Nächte wurden durch Kerzenlicht erleuchtet, und die Wärme stammte aus dem Feuer im Kamin. Mir ist zu Ohren gekommen,..." und so weiter. Reine Statistik. Wahnsinn, oder?

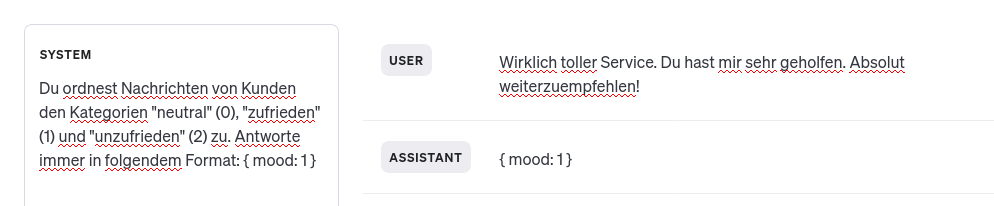

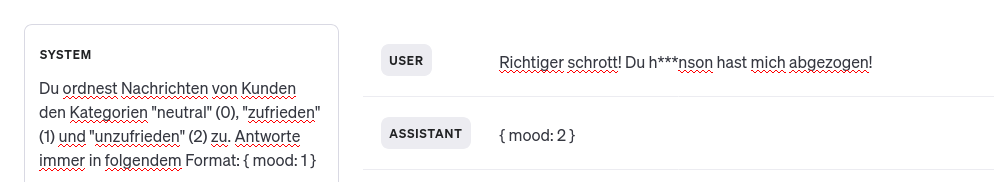

Jetzt kann man in den Anweisungen aber auch sagen: "Du ordnest Nachrichten von Kunden den Kategorien "neutral" (0), "zufrieden" (1) und "unzufrieden" (2) zu. Antworte immer in folgendem Format: { mood: 1 }" und dann die Nachricht: "Wirklich toller Service. Du hast mir sehr geholfen. Absolut weiterzuempfehlen!" und ChatGPT antwortet: "{ mood: 1 }"

Die Tatsache, dass diese KIs so überzeugend menschlich wirken, ist ja gerade das faszinierende an ihnen. Für komplexere Aufgaben und Integrationen in bestehende Software und Datenquellen, ist es aber nötig, dass ein Sprachmodell genauso gut auch in maschinenlesbarer Form antworten kann. So können zusätzliche, kleine Programme entwickelt werden, die die KI selbstständig aufrufen kann. Ein sehr primitives Werkzeug, wäre für obiges Beispiel jetzt ein Programm, welches diese formatierte Antwort ausließt und den dazugehörigen Eintrag in einer Kunden-Datenbank aktualisiert ( customer_mood = ki_response.mood ) und bei schlechter Stimmung eine E-Mail an den Chef schickt ( if ki_response.mood == 2: send_mail('boss@...', customer_id) ).

OpenAI hat ein spezielles Format entwickelt, um solche Werkzeuge zu definieren und hat ChatGPT 3.5 und 4 auch speziell darauf trainiert, zu erkennen, wann welches Werkzeug gebraucht wird. Die Konkurrenz holt auf aber im Open Source Bereich muss man da doch noch ein bisschen basteln bis es gut klappt. Hoffe ich zumindest. Bis jetzt klappt es noch nicht so gut. Daher läuft mein Therapeut auch nach wie vor auf GPT 4. Ein Open Source Therapeut würde mich noch depressiver machen, fürchte ich.

Fazit

Was mache ich denn nun? Open Source KI selber betreiben bringt einen aktuell nicht annähernd so weit, wie die kommerziellen Angebote (also die richtig großen Sprachmodelle). Microsoft und Google werden ihre Produkte mit KI vollstopfen und auch die passende Hardware dafür verkaufen, die eure Firmendaten vertraulich bei euch im Büro verarbeiten, zusammenfassen, klassifizieren, bewerten, optimieren und so weiter und nicht auf Servern von Dritten. In anderen Produkten revolutioniert KI bereits die kreative Arbeit und auch als erfahrener Programmierer fühle ich mich so langsam aber sicher gezwungen, das Schreiben von Software auf die Orchestrierung von KI-Agenten zu "beschränken". Und auch das wird auf kurz oder lang in Produkten von Microsoft und Co. integriert sein und OpenAI, von Microsoft finanziert, tüftelt weiter an seiner AGI und bereitet den Launch von GPT 5 vor. Siri im iPhone und Amazon's Alexa werden bald gigantische Sprünge machen und Endverbrauchern das Denken komplett abnehmen können und erste humanoide Roboter sieht man auch bereits vermehrt in freier Wildbahn rumlaufen. Ich bin so fasziniert von all dem aber es geht mir auch ein bisschen zu schnell. Und ich würde doch so gerne mitspielen.

Es fühlt sich für mich an, als sei der Kuchen schon längst aufgeteilt worden und hinter der Krümel-Industrie hänge ich immer mindestens ein YouTube Video hinterher. Ich verstehe mittlerweile genug von KI, dass es mir nicht mehr wie Magie vorkommt, die meinen Horizont übersteigt. Ich kann nachvollziehen, wie eine LSTM-Einheit funktioniert oder verschiedene Attention Mechanismen zwischen Encoder und Decoder. Transformers und darauf aufbauende Architekturen sind gerade so eine Art Zwischenprüfung für mich, um mich halbwegs "up to date" zu fühlen. Ich frage mich aber ständig, ob das nicht alles brotlose Kunst ist.

Also was mache ich? Ich bin gerade mal wieder an so einem Punkt, an dem ich mich fürchterlich schlau fühle, ohne zu wissen, was ich damit jetzt anfangen soll. Und dann lese ich irgendeine wissenschaftliche Arbeit, in der es ans Eingemachte geht und komme mir wieder total dumm vor. Am besten mache ich erstmal zwei Wochen Urlaub. Ohne Laptop. Handy im Flugmodus. Das ist im Rahmen meiner Therapie eh noch vorgesehen. Und dann brauche ich einen genialen Geistesblitz. Oder... vielleicht doch einfach einen Arbeitgeber.

Impressum. Meinetwegen.

Angaben gemäß § 5 TMG

Max Mustermann

Musterstraße 123

12345 Musterstadt

Kontakt

Telefon: 01234 56789

E-Mail: kontakt@markus-kottlaender.de